Der perfekte Scharfschütze

Wie schwer ist es, mit einem Schuss aus großer Entfernung exakt in die Mitte einer Zielscheibe zu treffen, die an eine Wand gezeichnet ist? Das könnte in etwa so schwierig sein, wie eine Handelsstrategie zu finden, die an den Märkten eine überdurchschnittliche Rendite erzielt.

Doch man kann es sich mit der Zielscheibe auch leichter machen, indem zuerst in die Wand geschossen und dann die Markierung ringsherum gezeichnet wird. Das mag zwar lächerlich klingen, wird aber in der Kapitalmarktforschung regelmäßig praktiziert, um Volltreffer zu produzieren. Der US-Wirtschaftsprofessor Gary Smith beschreibt diese Vorgehensweise treffend als „Texas Sharpshooter Fallacy“. [1]

Etwas extrem Unwahrscheinliches ist gar nicht unwahrscheinlich, wenn es bereits passiert ist. (Gary Smith)

Das Beispiel ist natürlich überspitzt, aber macht dennoch einen wichtigen Punkt klar: Gemeinsame Merkmale von Unternehmen zu untersuchen, die schon im Vorfeld als erfolgreich ausgewählt wurden, ist nicht besonders aussagekräftig. Smith zufolge ist stattdessen die wissenschaftliche Methode anzuwenden:

- Auswahl der zu untersuchenden Merkmale im Voraus und logische Begründung, warum sie den späteren Erfolg vorhersagen

- Auswahl von Unternehmen im Voraus, die diese Merkmale aufweisen sowie von Unternehmen, die sie nicht aufweisen

- Analyse des Erfolges in den nächsten Jahren anhand zuvor festgelegter Kriterien

Falsche Entdeckungen

Wer auf diese Weise nach erfolgreichen Handelsstrategien sucht, wird feststellen, dass es nur sehr wenige davon gibt. Der Grund dafür ist der starke Wettbewerb an den Märkten, der zu einem hohen Maß an Effizienz führt. Wenn doch eine profitable Strategie entdeckt wird, funktioniert sie meist nur für eine begrenzte Zeit. Gleichzeitig ist die Gefahr dafür, falsche Entdeckungen zu machen, sehr groß. Denn anders als in den Naturwissenschaften lassen sich statistische Erkenntnisse an den Märkten kaum durch kontrollierte Experimente überprüfen.

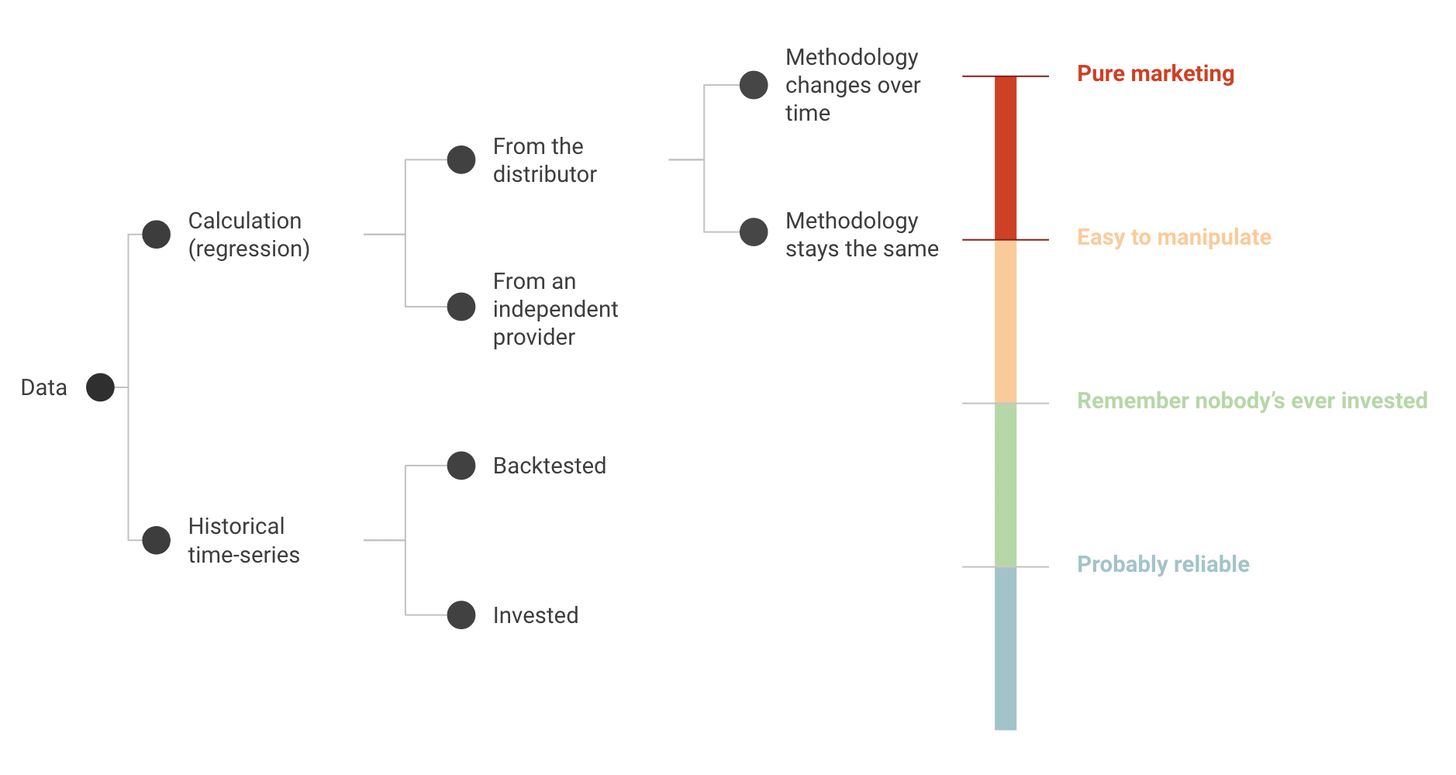

Ein Beispiel sind alternative Anlageklassen wie Wein oder Kunst, die sich angeblich besser entwickelt haben als der Aktienmarkt. Schaut man genauer hin, stammen die Daten meist oft von Vermögensverwaltern, die sich in diesen Assets engagieren, was einen klaren Interessenkonflikt darstellt. Die folgende Grafik von Factor Research zeigt, bei welchen Datenquellen man vorsichtig sein sollte, wenn es um die Beurteilung der Zuverlässigkeit geht. [2]

Quelle: FactorResearch

Gleichzeitig sind sich viele Anleger nicht bewusst, dass hohe Standards notwendig sind, um einem Ansatz wirklich vertrauen zu können. Also wird oft gekauft, was gut aussieht – unter der Annahme, dass die Entwickler schon wissen, was sie tun. In Wahrheit wird die Finanzindustrie aber von überoptimierten Backtests dominiert, die in ihrer Umsetzung früher oder später zu herben Enttäuschungen führen. Doch wie kann es sein, dass ein solch unprofessionelles Vorgehen zur gängigen Praxis wurde?

Das Problem mit den Backtests

Eine Erklärung ist die Art und Weise, wie Rückrechnungen von Anlagestrategien durchgeführt werden. Die Entwickler verwenden meist historische Marktdaten, die computergestützt auf eine Vielzahl von Kriterien, Gewichtungen und Kombinationen untersucht werden. Daraus lässt sich ein optimales Design ermitteln und eine potenzielle Rendite angeben, die sich auf Grundlage der Simulationen erwarten lässt.

Wie das Paper „Finance Is Not Excused“ beschreibt, entstehen daraus überoptimierte Rückrechnungen, die für die Zukunft nicht aussagekräftig sind. [3] Der Grund dafür ist, dass im Verhältnis zur verfügbaren Datenmenge viel zu viele Varianten ausprobiert und damit (unbewusst) zufällige Muster als relevant berücksichtigt werden. Das Ergebnis: Scheinbar gute Strategien enttäuschen in der praktischen Umsetzung, dem „ehrlichsten“ aller Out of Sample Tests.

Quelle: Huang, S. / Song, Y. / Xiang, H. (2020), The Smart Beta Mirage, S. 5

Die obige Grafik zeigt als Beispiel zwei Smart-Beta-Indizes relativ zum Markt. Beide bilden den gleichen Faktor ab – der graue Verlauf in der ursprünglich 1997 erstellten und der rote Verlauf in der 2014 verbesserten Variante. Während die ursprüngliche Variante keine Outperformance erzielte, sah die neue Version rückblickend deutlich besser aus. Dann wurde ein ETF aufgelegt, der natürlich den neuen Index abbildete. Doch dessen bessere Performance trat wohl nur im Backtest auf. Direkt ab Auflage underperformte der Fonds. [4]

Die hohe Rechenkapazität moderner Computer hat das Problem weiter verschärft. Heute können problemlos Millionen oder Milliarden an Parameterkombinationen untersucht werden. Und wenn die Entwickler dann „signifikante“ statistische Muster finden, ist es nicht weiter schwierig, eine dazu passende Erklärung ringsherum zu zeichnen – ähnlich wie es eingangs der clevere Scharfschütze tat. Leider scheint das der Studie zufolge auch bei der Entwicklung von Anlagestrategien die Regel zu sein, und nicht etwa die Ausnahme.